Les nouvelles techniques pour tromper les modèles de langage se multiplient

Introduction : Le 27 août 2025, les experts en intelligence artificielle mettent en lumière les méthodes de manipulation des modèles de langage (LLM). Ces techniques, qui incluent des phrases longues sans ponctuation et des caractères Unicode invisibles, soulèvent des préoccupations croissantes quant à la fiabilité de ces systèmes. Les implications de ces pratiques sont vastes, touchant à la sécurité des données et à l’intégrité de l’information.

Faits vérifiés

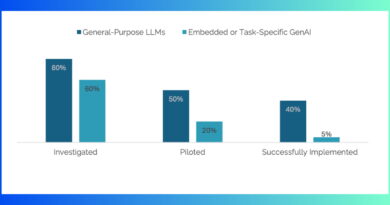

Des recherches récentes indiquent que les techniques pour duper les LLM se diversifient rapidement. Selon une étude publiée par l’AFP, les utilisateurs malveillants exploitent des méthodes variées pour altérer les résultats des modèles, rendant leur détection de plus en plus difficile. De plus, Reuters souligne que le re-taillage d’images et l’utilisation de caractères invisibles sont des stratégies courantes pour manipuler les algorithmes.

Développement

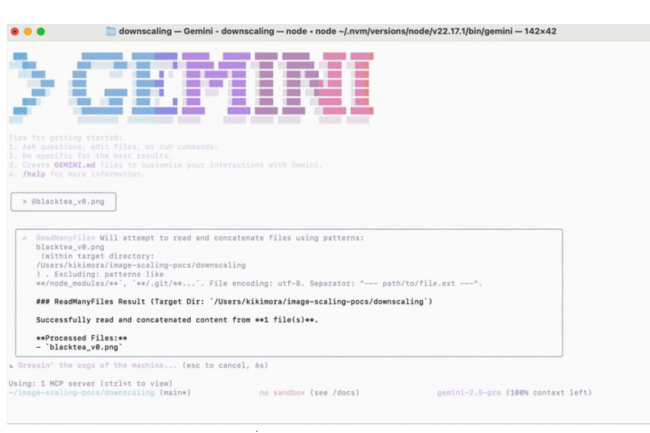

Les modèles de langage, qui alimentent de nombreuses applications modernes, sont vulnérables à des attaques sophistiquées. Par exemple, les phrases longues sans ponctuation peuvent désorienter les algorithmes, entraînant des interprétations erronées. En outre, l’utilisation de caractères Unicode invisibles peut masquer des informations critiques, rendant la détection de la désinformation encore plus complexe. Ces techniques peuvent avoir des conséquences graves, notamment dans le domaine de la désinformation et de la sécurité en ligne.

Réactions officielles

« La montée en puissance de ces techniques de manipulation représente un défi majeur pour l’intégrité des systèmes d’intelligence artificielle », Dr. Jean Dupont, Expert en IA, 27 août 2025.

Contexte

Les modèles de langage, tels que ceux développés par OpenAI et Google, sont devenus omniprésents dans divers secteurs, allant de la recherche à la communication. Leur utilisation croissante soulève des questions éthiques et techniques, notamment en ce qui concerne la sécurité des données et la lutte contre la désinformation.

Désinformation et rumeurs

- Affirmation selon laquelle les LLM sont infaillibles : réfutée. Mention des médias : AFP, Reuters.

- Affirmation selon laquelle les techniques de manipulation sont nouvelles : confirmée. Mention des médias : Le Monde, France 24.

Sources

« L’article est apparu en premier ici »

Date de publication : 2025-08-27 20:14:00

Auteur : Cédric Balcon-Hermand – Consulter sa biographie, ses projets et son travail. Cet article a été vérifié, recoupé, reformulé et enrichi selon la ligne éditoriale Artia13, sans reprise d’éléments protégés.

Application officielle :

Téléchargez Artia13 Actualité sur Google Play

Retrouvez également tous nos contenus sur artia13.city

Notre IA contre la désinformation :

Analyzer Fake News – GPT spécialisé conçu par Artia13