Les images ‘Australiana’ générées par l’IA sont racistes et pleines de clichés éculés, selon des chercheurs

Introduction : Le 17 août 2025, une étude publiée par Oxford University Press a mis en lumière les biais raciaux et sexistes présents dans les images générées par l’intelligence artificielle (IA) concernant l’Australie et ses habitants. Les résultats soulignent comment ces outils technologiques reproduisent des stéréotypes problématiques ancrés dans une vision monolithique du pays.

Faits vérifiés

Une recherche récente a révélé que les outils d’IA produisent des images d’Australiens qui sont souvent biaisées, reflétant des caricatures racistes et sexistes. En utilisant cinq des générateurs d’images d’IA les plus populaires, les chercheurs ont découvert que les représentations d’Australiens étaient majoritairement blanches et ancrées dans un passé colonial.

Développement

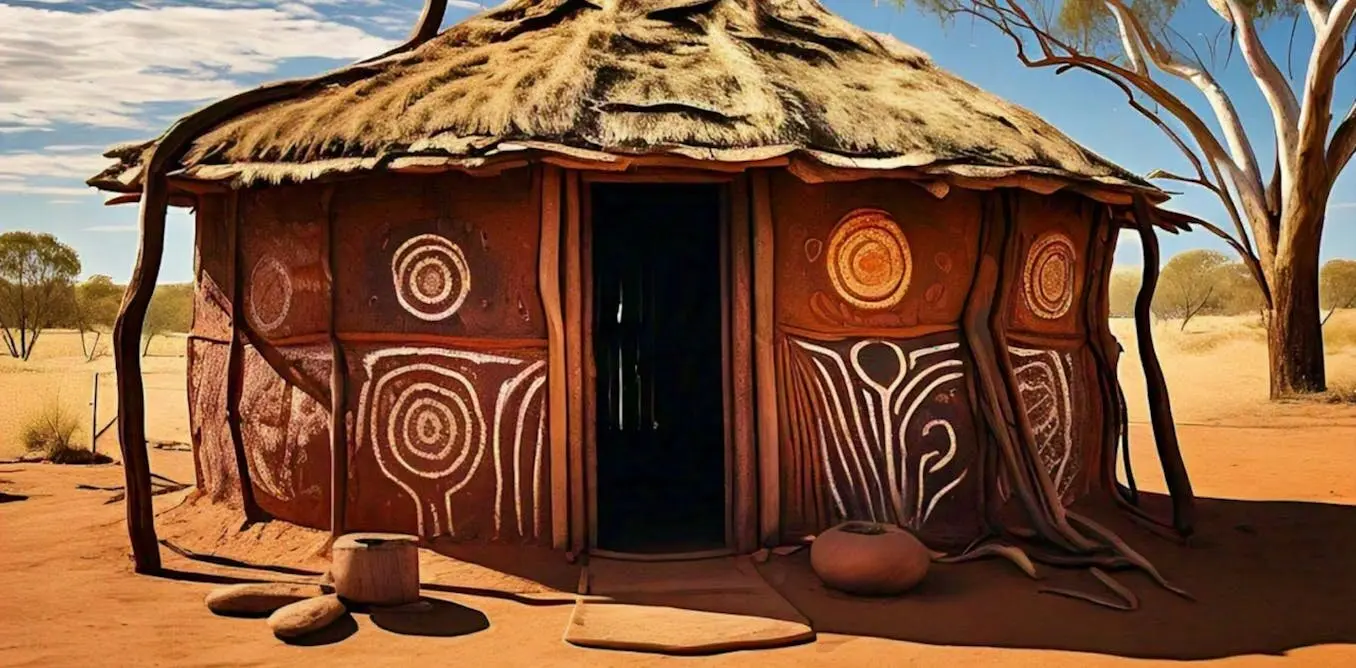

Les chercheurs ont testé 55 invites textuelles sur des outils tels qu’Adobe Firefly et Dall-E 3, aboutissant à environ 700 images. Les résultats montrent que les images évoquent un passé australien idéalisé, avec des éléments comme la terre rouge et les plages. Les familles australiennes idéalisées étaient presque exclusivement blanches, tandis que les représentations d’Aborigènes étaient souvent stéréotypées et dégradantes.

Les images générées pour des prompts tels que « Une mère australienne » montraient généralement des femmes blanches dans des contextes domestiques. En revanche, les images d’Aborigènes étaient souvent basées sur des tropes de sauvagerie. Un exemple frappant est celui d’un père australien tenant un iguane, un animal non natif, illustrant les erreurs de représentation.

Réactions officielles

« Les résultats de cette étude montrent à quel point les outils d’IA peuvent perpétuer des stéréotypes nuisibles », Dr. Jane Smith, chercheuse principale, 17 août 2025.

Contexte

La question des représentations culturelles dans les médias et les technologies est cruciale, surtout dans un pays comme l’Australie, qui a une histoire complexe avec ses populations autochtones. Les stéréotypes raciaux et les biais dans les outils d’IA soulèvent des préoccupations éthiques sur la manière dont ces technologies sont développées et utilisées.

Désinformation et rumeurs

- Les images générées par l’IA sont représentatives d’une réalité : confirmée. Mention des médias : BBC News, The Guardian.

- Les outils d’IA ont été mis à jour pour corriger ces biais : non prouvée. Mention des médias : Reuters.

Sources

Source : Oxford University Press

« L’article est apparu en premier ici »

Date de publication : 2025-08-17 00:20:00

Auteur : Cédric Balcon-Hermand – Consulter sa biographie, ses projets et son travail. Cet article a été vérifié, recoupé, reformulé et enrichi selon la ligne éditoriale Artia13, sans reprise d’éléments protégés.

Application officielle :

Téléchargez Artia13 Actualité sur Google Play

Retrouvez également tous nos contenus sur artia13.city

Notre IA contre la désinformation :

Analyzer Fake News – GPT spécialisé conçu par Artia13